Merhaba!

Bu yazımda size Zeynep Tüfekçi'den ve yapay zekâ üzerindeki fikirlerinden bahsedeceğim.

2006'da doçent olan Zeynep Tüfekçi, teknolojinin siyaset ve toplum üzerine etkileri hakkında çalışmalar yapmaktadır. Toplumsal hareketler ve sosyal medyanın ilişkisi, özel hayat ve elektronik izleme, sosyal etkileşim alanlarında akademik çalışmalar yaptığı bilinen Tüfekçi, aynı zamanda Harvard Üniversitesinde danışman öğretim üyesi ve Princeton Üniversitesinde de araştırmacı olarak görev yapmaktadır. Başarılı hayatını anlatmak için elbette bu kadar cümle yeterli değil, ancak bu yazı için bizi ilgilendiren kısmi fikirleri…

Öngörüleriyle gündeme gelen Zeynep Tüfekçi:

- 2011'de Twitter'ın toplumsal hareketlerin itici gücü olmasının basite indirgendiğini belirtti.

- 2012'deki haberlerin okul saldırılarını teşvik edebileceği konusunda uyardı.

- 2013'te Facebook'un etnik temizlik fikirlerini körükleyebileceğini söyledi.

- 2017'de ise YouTube'un öneri algoritmasının bir radikalleşme aracı olarak kullanılabileceğini ifade etmişti.

Sosyolog ve bilgisayar programcısı olmanın getirdiği bilgi birikimi ile yaptığı "Ted Talks" konuşmaları da çok ses getirmişti.

Şimdi size kendisinin yapay zekâ hakkındaki düşüncelerini anlatacağım.

Bilgisayar programlamacısı olarak işe başlayan Zeynep Tüfekçi, günümüzde bilgisayar uzmanlarının her gün milyarlarca insanın göreceği şeyleri kontrol eden programlar kurduğunu belirterek devam ediyor:

"Günümüzde programlamacıların öyle güçlü ve etkili yerleri var ki; kime çarpacağına karar verecek arabalar geliştiriyorlar. Savaşta canlıları öldüren makineler, silahlar bile geliştiriyorlar.

Makine zekâsı işin içinde. Artık herhangi bir karar verirken bilgisayar kullanıyoruz, bilgisayara tek bir doğru cevabı olmayan öznel, açık uçlu ve değer yüklü sorular soruyoruz. Örneğin;

- Şirket kimi işe almalı?

- Hangi arkadaştan hangi güncellemeyi görmelisiniz?

- Hangi mahkûm tekrar suç işlemeye yatkın?

- İnsanlara hangi haber ya da film tavsiye edilmeli?

Örneklerde olduğu gibi öznel kararlarda, uçak uçurma, köprü inşa etme, aya gitme konularında güvendiğimiz gibi güvenmemeliyiz.

Son 10 yılda karmaşık algoritmalar büyük aşamalar kaydetti

İnsan yüzlerini tanıyabiliyorlar.

El yazılarını çözebiliyorlar.

Kredi kartı dolandırıcılığını tespit ediyorlar.

Spam mailleri engelliyorlar.

Diller arası çeviri yapabiliyorlar.

Tıbbi görüntülemelerde tümörü teşhis edebiliyorlar.

Satrançta insanı yenebiliyorlar.

Bu gelişmelerin çoğu makine öğrenimi denilen bir yöntemden geliyor

Makine öğrenimi geleneksel programlamadan farklıdır. Daha çok sistemi kavrayıp onu dijital yaşamlarımızda ürettiğimiz yapısal olmayan veri dahil bir sürü veriyle desteklemeniz gibidir. Sistem bu bilgileri baştan sona öğrenir. Bu sistemler tek cevaplı mantıkla çalışmaz, "belki de aradığınız şey bu olabilir…" der. Avantajı ise sistemin gücüdür. Dezavantajı ise sistemin ne öğrendiğini tam olarak anlayamamamızdır. Nasıl kontrol edeceğimizi bilmediğimiz bir içecek sıkma makinesini çalıştırmak gibi…

Örneğin işe alım için makine öğrenmesi algoritmasından yararlanıldığını düşünelim. Böyle bir sistem önceki çalışanların verilerine dayalıdır ve şirketteki yüksek performansı olan çalışanlar gibi insanlar bulmaya sonrasında ise onları işe almaya kurulmuş olmalı.

Bu yöntemin daha nesnel, daha az ön yargılı olduğu düşünülüyor

Bu sistemler, kendileriyle paylaşılmasa bile dijital ayak izlerinden hakkımızda birçok çıkarım yapabiliyor:

- Cinsel yönelim

- Kişisel özellikler

- Siyasi görüş gibi

paylaşmadığımız şeyleri bile bilebiliyor, yani çıkarımda bulunuyorlar.

Sosyal medya verilerinden klinik depresyon veya doğum sonrası depresyon ihtimalini öngören sayısal sistemler geliştiren bir arkadaşım var. Sistem, depresyon ihtimalini semptomların başlamasından aylar önce öngörebiliyor. Bu sistemin erken müdahalede kullanılabileceği düşünülüyor.

Şimdi bunu işe alım sisteminde göz önünde bulundurun.

Ya sistem gelecekte yüksek depresyon ihtimali olan insanları ayıklıyorsa?

Kişinin şu an psikolojik bozuklukları yok, fakat ileride olabilir ya da şu an hamile olmayan kadınların ileride hamile olma olasılıklarını göz önünde bulundurarak ayıklama işlemi yapıyor olabilir….

Sadece sistemin neyi seçtiğini değil nereden başlamanız gerektiğini de bilemiyorsunuz.

Kara kutu, tahmin gücü olan bir kara kutu

Kara kutu algoritmaların öne sürdüğü gizli ön yargıların hayat değiştiren sonuçları var.

Şartlı tahliye ve cezalarda artık algoritmaların kullanıldığını biliyorsunuz.

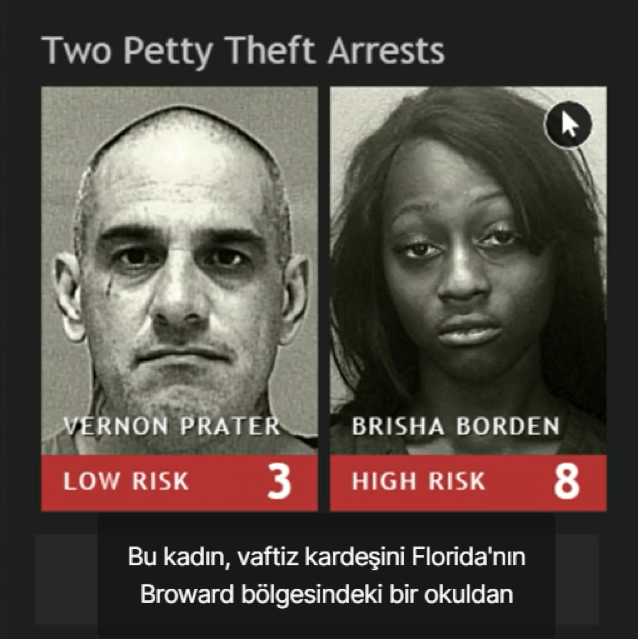

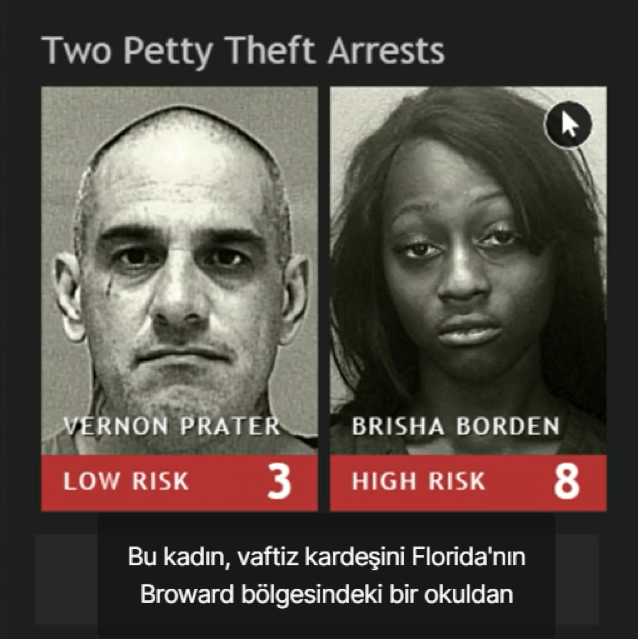

Kâr amacı gütmeyen araştırmacı kurum ProPublica bir algoritmayı inceledi ve sonuçlarının ön yargılı olduğunu, öngörü gücününse kötü olasılıktan biraz iyi olduğunu, siyah sanıkları haksız yere beyaz sanıklardan iki kat fazla bir oranla geleceğin suçluları olarak etiketlediğini bulguladı.

Resimdeki kadın, üvey kardeşini Florida'nın Broward bölgesindeki bir okuldan almaya geç kalıyor, verandada duran kilitsiz bir çocuk bisikletini alarak düşünmeden biniyor, tam yola çıkacakken kadın bu benim çocuğumun bisikleti diyor. Kadın bisikleti bırakıyor ancak tutuklanıyor. (Bunu yaparken 18 yaşında.)

Resimdeki adam ise Home Depot'ta hırsızlık yapmaktan tutuklanıyor, 85 dolar değerinde benzeri bir hafif suç işliyor, fakat öncesinde 2 silahlı soygun sabıkası var; ancak algoritma adamı değil, kadını yüksek riskli olarak işaretliyor.

2 yıl sonra ProPublica kadının tekrar suç işlemediğini, fakat adamın tekrar suç işlediğini tespit ediyor. (Şimdi de işlediği suç yüzünden 8 yıllık hapis cezasında.)

Belli ki kara kutularımızı kontrol etmeli ve onlara bu şekilde kontrolsüz güç vermememiz gerekiyor

Ağustos 2014'te afroamerikan bir gencin polis tarafından öldürülmesiyle protestoların başladığı sırada (Twitter'da her yer bu haberle doluyken) Facebook algoritması, haberin beğenilmeyeceğini düşünerek kendiliğinden filtre uygulamış… Onun yerine bizlere ALS Buz Kovası Düellosu'nu gösterdi.

Buzlu su dök bağış yap! Süper algoritma dostu, tam beğenmelik!

Algoritmaların insan gibi çalışmaması da bir sorun.

Bu algoritmalara ölümcül otonom silahlar bağlandığında "hata yapmak nedir" düşünmek bile istemeyiz. Evet, insanlar ön yargılıdır ve hata yaparlar, fakat bu zor konulardan kaçamayız; bu zor konuların çözümlerini makinelere bırakmamalıyız.

Yapay zekâ "etikten kurtul geç" imkanını vermiyor

Algoritmaları şüphe, gözlem ve inceleme ile desteklemeliyiz. İzlenebilirlik, denetim ve şeffaflık olduğundan emin olmamız gerek.

İnsan ilişkilerinin karmaşıklığı algoritmaları ele geçiriyor.

Tabii ki daha iyi kararlar almamız için bilgisayar kullanabiliriz, kullanmalıyız da…

Ancak doğru karar vermek için, ahlaki sorumluluk alıp algoritmaları bu çerçevede kullanmak zorundayız, insan olarak birbirimize karşı olan sorumluluklarımızı üstümüzden atıp dış kaynaktan temin etmenin bir yolu gibi görmemeliyiz. İnsani değerlere ve etiğe hiç olmadığı kadar sıkı sarılmamız gerekiyor."

Kaynaklar:

https://www.indyturk.com/node/232711/ya%C5%9Fam/nyt-abdnin-maske-karar%C4%B1n%C4%B1-de%C4%9Fi%C5%9Ftiren-zeynep-t%C3%BCfek%C3%A7iye-sordu-nas%C4%B1l-hep-hakl%C4%B1

https://tr.wikipedia.org/wiki/Zeynep_T%C3%BCfek%C3%A7i

https://www.ted.com/talks/zeynep_tufekci_machine_intelligence_makes_human_morals_more_important/up-next?language=so#t-1043627

İletişim: https://www.linkedin.com/in/nehir-gunce-dasci/